Hass findet man auf YouTube an vielen Orten. Doch Roger Köppels morgendlichen «Espresso gegen den Mainstream-Tsunami» scheinen besonders viele YouTube-Kommentierende schlecht zu ertragen: Beschimpfungen, Hassrede und Vulgäres machen einen wesentlichen Teil der Kommentare zu seiner Sendung «Weltwoche Daily» aus. Die Auswertung von 65’000 YouTube-Kommentaren zu Köppels Sendung zeigt: Der Wind weht zunehmend rauer. Eine Untersuchung.

Während andere noch schlafen, lässt Roger Köppel frühmorgens von Montag bis Freitag seinen Meinungen freien Lauf. Dann nimmt der rechtspopulistische SVP-Nationalrat und Chefredaktor des konservativen Magazins «Weltwoche» seinen Podcast «Weltwoche Daily» auf.

Sein Versprechen: Mit diesen Inhalten bekämen Zuhörende eine «andere Sicht», sie seien bei «Weltwoche Daily» vor der «Mainstreamlawine» sicher. Der mächtige Politiker folgt mit dem Verbreiten alternativer rechter Inhalte einem grösseren Trend, den angelsächsische Rechtsnationalisten wie Steve Bannon und Alex Jones losgetreten haben. Wie sie nimmt Köppel seine politischen Inhalte als Podcast auf, nennt es Journalismus und verbreitet das Produkt erfolgreich auf YouTube; hier sind rechte Inhalte in den letzten Jahren regelrecht explodiert (Munger & Philips 2021).

Mit Berichterstattung aus kritischer Distanz haben seine morgendlichen Monologe wenig zu tun: Er beklagt die Arroganz seiner politischen Gegner, wirft dem schweizerischen Bundesrat den Aufbau einer Diktatur vor und beleidigt Minderheiten. Oder aber er wirft Gegnern die willentliche Zerstörung der Wirtschaft vor und beschimpft die Medien als «Einheitsbrei» und unangemessen staatsnah.

Neben scheinbarem Erfolg – Köppels Sendungen weisen im analysierten Zeitraum über vier Millionen Aufrufe vor – bringt «Weltwoche Daily» auch einige verdorbene gesellschaftliche Früchte zum Vorschein.

Tausende toxische Reaktionen auf Köppels Podcasts

Auf die täglichen Sendungen folgten 8’600 toxische Kommentare – das allein zu den Episoden zwischen Januar 2020 und Ende April 2021. 6 % der Kommentare zu einer Sendung waren somit durchschnittlich als toxisch einzustufen. Das offenbart ein Algorithmus, der rund 65’000 Kommentare auf toxische Wortmeldungen untersucht hat.

Die toxischen Kommentare verleumden, beschimpfen und versuchen zu entwürdigen. Wortmeldungen mit fehlendem Anstand sind aber der harmloseste Teil der Kommentare. Landesverrat, Korruption, Pädophilie oder Satanismus – das wollen Kommentierende Minderheiten und Personen des öffentlichen Lebens grundlos anhängen und sie damit in Verruf bringen. Aufgrund ihrer oft strafbaren Natur werden die toxischen Inhalte an dieser Stelle nicht wörtlich wiederholt, sondern nur umschrieben.

💡 Was sind toxische Kommentare? 💡

Der verwendete Algorithmus zählt Folgendes zu den toxischen Kommentaren: Beleidigungen, Herabwürdigungen von Menschen bezüglich ihrer z.B. religiösen, nationalen, sozialen Zugehörigkeit (im Volksmunde auch Hate Speech) sowie vulgäre Sprache.

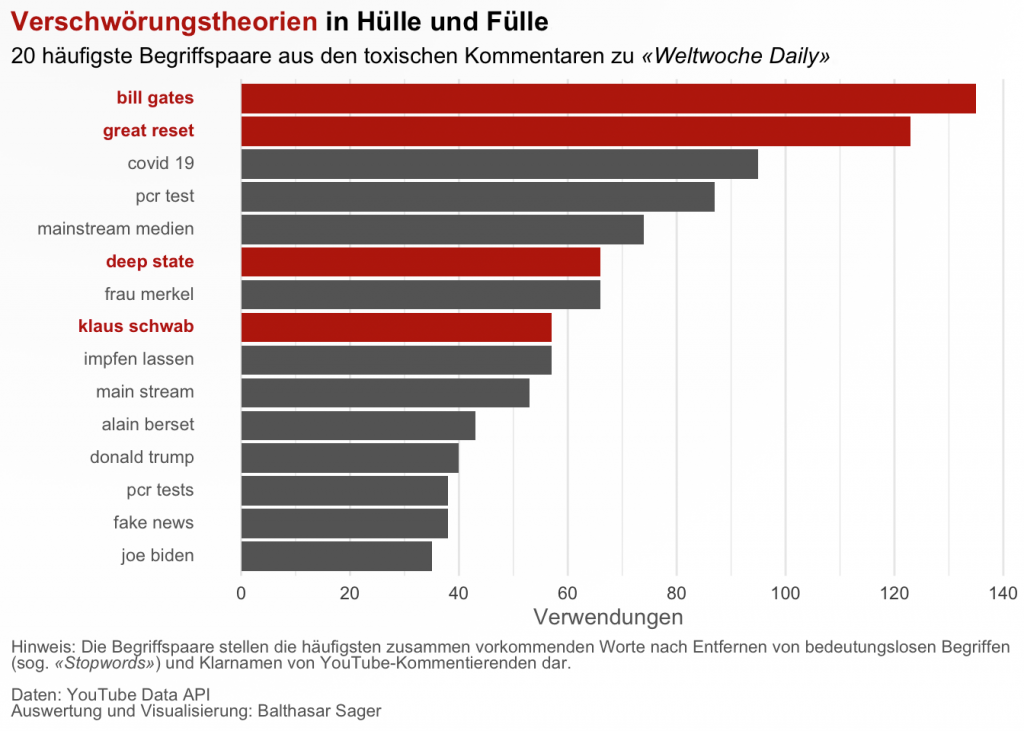

Verschwörungstheorien sehr prominent

Die 20 meistverwendeten Begriffspaare, dargestellt in der nächsten Grafik, enthüllen die prominente Rolle, die Verschwörungstheorien in den toxischen Wortmeldungen einnehmen.

Das häufigste Begriffspaar «bill gates» bezieht sich auf verschiedene Geschmacksrichtungen des böswilligen Vorwurfs an den Milliardär die COVID-19 Pandemie zum eigenen Profit kreiert zu haben (Kelland 2021). Sein Ziel sei das Erlangen der Weltherrschaft durch das Implantieren von Mikrochips durch die Impfung gegen das Coronavirus.

Ähnliches wird dem World Economic Forum (und dessen Gründer, Klaus Schwab) vorgeworfen – das unter den Begriffen «great reset» und «klaus schwab» (Goodman & Carmichael 2021). Weiter spielt auch der Begriff «deep state» auf eine permanente, ungewählte Schattenregierung an, welche ungezügelt Macht an sich gezogen haben soll (Rohde 2020). Oft bezogen sich toxische Kommentare auch auf die Personen Donald Trump, Alain Berset, Joe Biden und Angela Merkel.

Der Wind weht zunehmend rauer

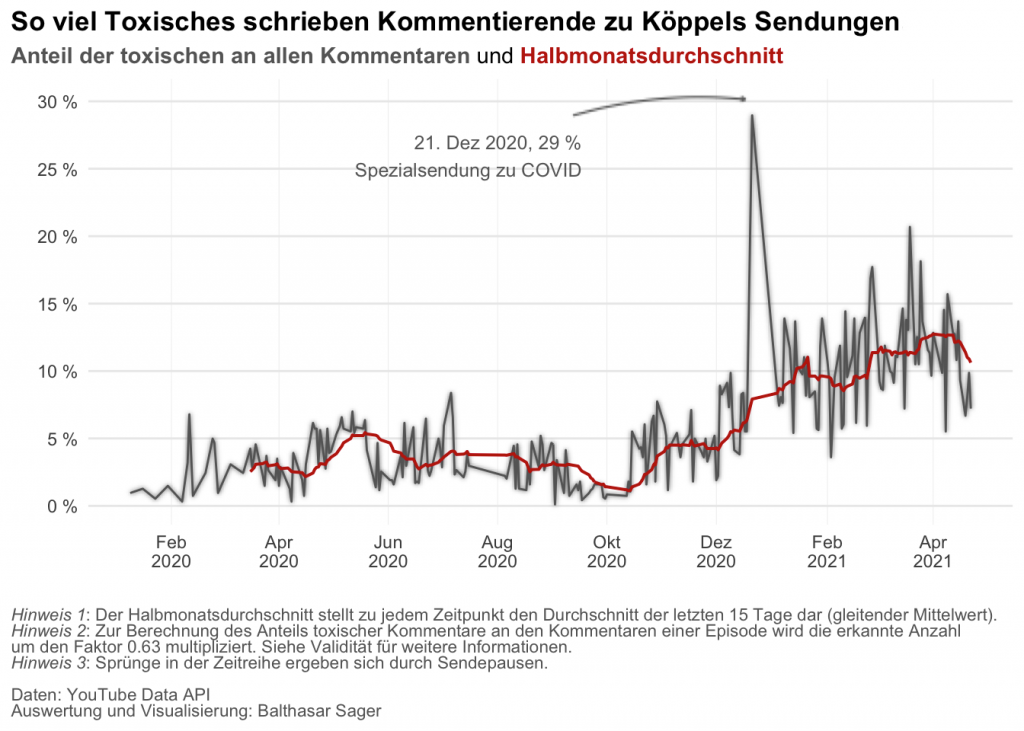

Seit letztem Dezember ist das Klima in den YouTube-Kommentaren zunehmend giftiger geworden. Die Statements zu den diesjährigen Sendungen zeigen deutlich höhere Anteile toxischer Kommentare als letztes Jahr. Bis Dezember 2020 betrug der durchschnittliche Anteil toxischer Kommentare kaum mehr als je 5 % – ab Anfang 2021 hat sich ihr Halbmonatsdurchschnitt mehr als verdoppelt.

Das demonstriert auch die nächste Abbildung: Kommentarspalten zu Sendungen in 2021 verzeichneten deutlich höhere Anteile toxischer Kommentare als jene aus 2020.

Das wirft die Frage auf: Wann wird besonders viel Toxisches geschrieben? Die Gegenüberstellung von Sendungsinhalten und toxischen Kommentaren bietet eine Erklärung.

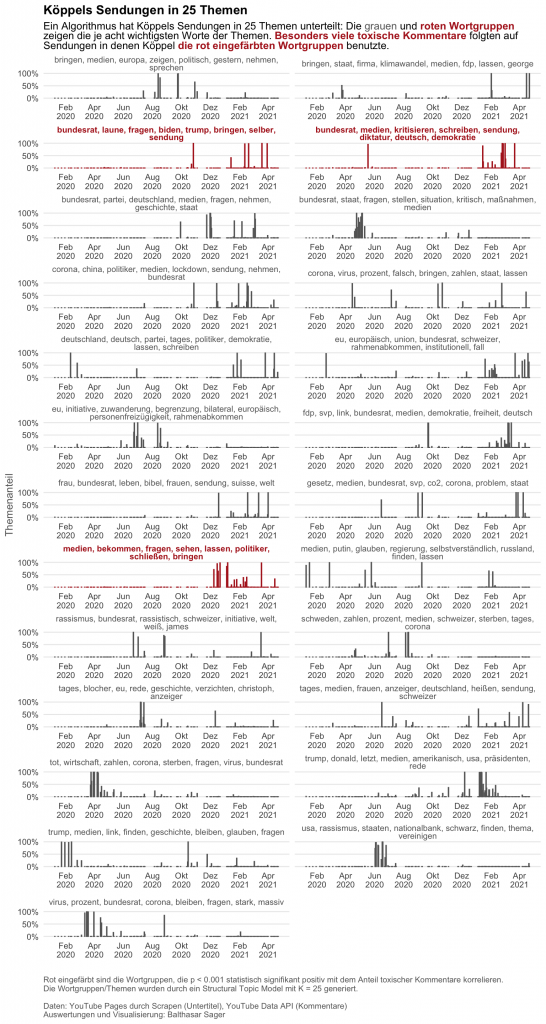

Kommentierende schäumten nach Sendungen mit Diktaturvergleichen

Je nachdem, mit welchen Worten Köppel zum Beispiel die Bundesratspolitik kommentierte, schrieben Kommentierende unterschiedlich viele toxische Kommentare. Wo Köppel die Bundesratspolitik als Diktatur bezeichnete machten toxische Wortmeldungen in den Kommentaren einen statistisch signifikant höheren Anteil aus. Kommentierte er die Regierungspolitik anderweitig waren solche Sprünge im Anteil der Kommentarspalte mit Ausnahmen nicht systematisch zu erkennen. Übte Köppel Kritik an den Medien oder sendete er zum Thema US-Politik mit Fokus auf Joe Biden liessen sich ebenfalls systematisch erhöhte Zahlen toxischer Kommentare beobachten.

Diese Zusammenhänge zeigt auch die nächste Abbildung. Sie legt den Anteil 25 wichtiger Sendungsthemen für «Weltwoche Daily» über Zeit dar. Dafür identifizierte ein Textalgorithmus (siehe Roberts 2014) in den Untertiteln zu den Sendungen 25 wichtige Begriffsgruppen. Diese Begriffsgruppen bestehen aus Wörtern, die Köppel oft gemeinsam verwendete (z.B. «bundesrat, medien, kritisieren, schreiben, sendung, diktatur, deutsch, demokratie»).

Ein Beispiel: In der Episode vom 26. Februar 2021 erzürnt sich der in den Ferien weilende Köppel über die Schliessung von Terrassen von Bergrestaurants: Den Taliban ähnlich sei das, eine «Diktatur». Im selben Atemzug ermahnt der Politiker wie die nationalsozialistische Herrschaft Hitlers auf legalem Wege eingeführt worden sei. Rund 18 % der Kommentare zur Sendung waren danach toxischer Natur – drei mal so viel wie der Durchschnitt in der analysierten Zeitspanne.

Aber aufgepasst: Es wäre falsch, Köppels Rhetorik als Ursache für mehr toxische Kommentare zu identifizieren. Köppels Kommunikation ruft sicherlich gewisse Emotionen in den Zuhörenden hervor, zumal er ein begabter Rhetoriker ist. Trotzdem widerspiegeln toxische Kommentare nicht zwingend Köppels Argumentationsschema – aktuelle Ereignisse oder die politischen Präferenzen der Kommentierenden könnten diese ebenso erklären. Somit kann keine Kausalität festgestellt werden.

Mit Macht kommt Verantwortung

Zu einer funktionierenden Demokratie gehören zivilisierte und sachliche Auseinandersetzungen. Diese dürfen in der Sache hart sein, sollen aber weder gesellschaftliche Werte schädigen noch andere Personen in ihrer Ehre verletzen.

Köppel billigt durch seine Untätigkeit eine schlechte Diskussionskultur. Weshalb herabwürdigende und teilweise strafbare Äusserungen auf YouTube sichtbar bleiben, die auf der «Weltwoche»-Webseite gemäss eigenen Regeln gelöscht würden, leuchtet nicht ein (Weltwoche Verlags AG 2021).

Auch YouTube trifft eine Verantwortung: Die Diskussionskultur auf der Plattform ist seit Jahren ein ungelöstes Problem (Baldwin 2013, Biermann 2013, Perez 2020). Zwar löscht die Plattform gemeldete Kommentare, jedoch erst, wenn diese als Verstoss gegen die Community-Richtlinien klassifiziert worden sind. Letztere widerspiegeln grosszügige amerikanische Vorstellungen der Meinungsfreiheit – oft von Radikalisierten zu ihren Gunsten missbraucht.

Denn spätestens wenn Hassrede wie aktuell dazu führt, dass die Bundespolizei Fedpol vor Berner Verwaltungsgebäuden patrouillieren muss (Michel & Hourni 2021), ist es Zeit, die Bedrohung durch politischen Extremismus ernst zu nehmen.

Informationen zum Blogbeitrag

Titel: In den Kommentaren zu Roger Köppels YouTube-Sendung finden sich strafbare Äusserungen und Verschwörungstheorien. Eine Übersicht.

Name: Balthasar Sager

Anzahl Worte: 999

Code: Alle Auswertungen sind frei auf Github einsehbar, die Rohdaten lassen sich mit einem YouTube API Key erstellen.

Abgabedatum: 20. Juni 2021

Seminar: Forschungsseminar Politischer Datenjournalismus (FS 2021) Dozierende: Theresa Gessler, Alexandra Kohler, Bruno Wüest, Virginia Wenger (Tutorin)

Validität

Datenset

Kommentare: Analysiert wurden 64’793 YouTube-Kommentare zu 241 «Weltwoche Daily»-Sendungen bzw. allen Videos im YouTube-Kanal «DIE WELTWOCHE (Wochenmagazin)», die den Begriff «Weltwoche Daily» im Titel hatten. Da die YouTube Data API eine Limite zu den täglichen Downloads vorsieht, beschränkt sich diese Analyse auf Kommentare und Antworten auf diese. Antworten auf Antworten sind unter Umständen somit nicht vorhanden. Somit werden 64’793 von insgesamt 72’010 Kommentaren bzw. 89.97 % der analysierten Zeitspanne abgedeckt. Unklar ist, wie viele Kommentare zum Zeitpunkt des Datenbezugs schon gelöscht wurden, was einen Einfluss auf die Anzahl als toxisch erkannter Kommentare hat.

Untertitel: Automatisch von YouTube generierte hochdeutsche Untertitel zu 185 Sendungen wurden ebenfalls generiert. Hier fehlt ein Teil, was in den Topic Models zu verzerrten Topics führen könnte (siehe unten für eine Erklärung).

Zeitraum: Die Analyse beschränkt sich auf den Zeitraum vom 09.01.2020 bis zum 22.04.2021, zuvor war die Sendefrequenz entgegen ihrem Titel im Wochendurchschnitt noch kaum «daily».

Datenaufbereitung, -analyse und -visualisierung

Alle Schritte erfolgten in der Programmiersprache R (R Core Team 2021). Verwendet habe ich für die Analyse vor allem Packages aus dem Tidyverse (Wickham et al. 2019). Alle Video Links, Metadaten und YouTube-Kommentare zu den Sendungen habe ich über die YouTube Data API (Google Developers 2021) mit einer selbst ergänzten Version (Sager 2021a) des R-Packages tuber (Sood 2021) bezogen. Untertitel wurden mit dem R-Package youtubecaption (JooYoung & Soyoung 2020) heruntergeladen.

Erkennung von toxischen Kommentaren

Für die Klassifizierung von toxischen Kommentaren verwende ich den vortrainierten Algorithmus deepset/bert-base-german-cased-hatespeech-GermEval18Coarse, der von deepset.ai auf der Algorithmus-Plattform Hugging Face publiziert wurde. Den Algorithmus portiert mein R-Package wrappingtransformers (Sager 2021b) von Python nach R.

Der Algorithmus wurde mit Tweets aus der Flüchtlingskrise 2018 trainiert: Rund 8000 Tweets wurden klassifiziert, ob toxisch bzw. beleidigend („offensive“) waren oder einen anderen Inhalt hatten (‚other‘), siehe dazu Wiegand et al. (2018, p. 2) zum sogenannten GermEval 2018 Datenset. Als toxischen Inhalt soll der Algorithmus Kommentare erkennen, die einem der folgenden drei verschiedenen Inhaltsarten entsprechen:

- Herabwürdigend aufgrund von Gruppenzugehörigkeit (‚Abuse‘): Herabsetzen durch die Zuschreibung einer sozialen Identität, die von einer (wahrgenommenen) Mehrheit der Menschen als beschämend, unwürdig, moralisch verwerflich oder randständig empfunden werden soll. Dafür muss die herabgesetzte Person als Vertreterin einer Gruppe identifiziert und ihr negative Eigenschaften zugeschrieben werden, die immer und unverändlich bei allen Mitgliedern der Gruppe zutreffen sollen. Zu Kategorie gehören auch Entmenschlichungen: Wenn jemand z.B. als Abschaum oder Ungeziefer bezeichnet wird.

- Beleidigend (‚Insult‘): Inhalte gilten als Beleidigungen wenn Personen beschimpft werden. Dabei wird die Verachtung gegenüber einer Person ausgedrückt.

- Profane Sprache (‚Profanity‘): Kommen Fluche oder Kraftwörter vor, giltet das als profane Sprache – dabei werden allerdings keine spezifischen Personen oder Gruppen beleidigt.

Modellgüte des Algorithmus und Validierung anhand von YouTube-Kommentaren

Die Modellgüte wurde an 250 zufällig gezogenen, von mir manuell auf Toxizität annotierten Kommentare geprüft. Folgende Werte wies der Algorithmus auf, wobei Positive = Toxisch:

- Confusion Matrix

- True Positives: 26.29 % bzw. 66

- False Negatives: 5.58 % bzw. 14

- False Positive: 23.9 % bzw. 60

- True Negatives: 44.22 % bzw. 111

- Weiter Metriken

- Sensitivity: 0.8250000

- Specificity: 0.6491228

- Pos Pred Value: 0.5238095

- Neg Pred Value: 0.8880000

- Precision: 0.5238095

- Recall: 0.8250000

- F1: 0.6407767

- Prevalence: 0.3187251

- Detection Rate: 0.2629482

- Detection Prevalence: 0.5019920

Der Algorithmus stufte zu viele Kommentare als toxisch ein. Deshalb wurde ein Korrekturfaktor berechnet, um den Anteil der toxischen Kommentaren an allen Kommentaren nach unten zu korrigieren:

- Anzahl Positives/bzw. toxische Kommentare: True Positives + False Negatives = 80

- Kommentare, die der Algorithmus als toxisch einstuft: True Positives + False Positives = 126

- Um wie viel Prozent ist die erkannte Gesamtzahl zu hoch: 1 – (True Positives + False Negatives)/(True Positives + False Positives) * 100 = 36.5079365 % bzw. 1 – 80/126

Damit entsteht der Korrekturfaktor von 80/126 = 0.6349206. Wenn der Classifier für ein Video z.B. 273 toxische Kommentare erkennt, ist die «echte» Zahl: 273 * 0.6349206 = 173.33.

Die einheitliche Anwendung des Korrekturfaktors auf die erkannte Anzahl toxischer Kommentare bei allen Sendungen führt dazu, dass die Schätzungen insgesamt konservativ ausfallen. Die einheitliche Anwendung unterliegt der Annahme, dass der Classifier bei den Kommentaren zu jeder Episode gleich daneben liegt, was nicht zwingend stimmt.

Identifizierung von Themen

Um welche Themen es in einer Episode geht, finde ich anhand eines sogenannten Structural Topic Models heraus (Roberts et al. 2019), das ich auf die automatisch generierten Untertitel zu den Episoden anwende. Damit lassen sich Gruppen oft zusammen vorkommender Begriffe generieren. Das Modell generiert für jedes Wort im Text einen Wahrscheinlichkeitswert (sog. Gamma-Werte), ob es in einem ‚Thema‘ bzw. Topic vorkommt. Zuvor muss die Anzahl zu entdeckender Topics definiert werden – ich habe das Modell für 10, 15, 20, 25 und 30 Topics gerechnet und mich aufgrund der entstehenden Topics für das Topic Model mit 25 Themen entschieden.

Identifizierung von Themen, auf die besonders viele toxische Kommentare folgten

Um herauszufinden, ob bei gewissen Sendungsthemen der Anteil von Toxischem an allen Kommentaren besonders hoch ist, wurden OLS-Regressionen gerechnet: Der Anteil aller durch das STM in den Untertiteln zu einer Sendung entdeckten Themen (unabhängige Variable) soll den Anteil toxischer Kommentare der jeweiligen Episode erklären (abhängige Variable).

Für ein STM-Modell mit 25 Topics sieht die Formel wie folgt aus: Anteil_toxischer_Kommentare_an_allen_Kommentaren ~ Beta_0 + Beta_1 * Anteil_Thema_1 + Beta_2 * Anteil_Thema_2 + Beta_3 * Anteil_Thema_3 + … + Beta_25 * Anteil_Thema_25.

Koeffizienten von Themen, die positiv und mit P < 0.001 mit dem Anteil toxischer Kommentare korrelieren, wurden im Artikel hervorgehoben. Die identifizierten Themen korrelieren bei K = 25 und K = 30. Wie im Artikel erwähnt, weisen die Korrelationen nicht zwingend darauf hin, dass Köppel Treiber der toxischen Kommentare ist.

Referenzen

- Álvarez-Benjumea, A., & Winter, F. (2020). The breakdown of antiracist norms: A natural experiment on hate speech after terrorist attacks. Proceedings of the National Academy of Sciences, 117(37), 22800-22804. https://doi.org/10.1073/pnas.2007977117

- Baldwin R. (2013). YouTube Tries to Clean Up the Filthiest Comments on the Internet. Wired. https://www.wired.com/2013/09/youtube-comments/?mbid=social12316904

- Biermann K. (2013). Google will YouTube zivilisieren. Die Zeit. https://www.zeit.de/digital/internet/2013-09/youtube-googleplus-kommentare

- Bilewicz, M., & Soral, W. (2020). Hate speech epidemic. The dynamic effects of derogatory language on intergroup relations and political radicalization. Political Psychology, 41, 3-33. https://doi.org/10.1111/pops.12670

- Biswal, C. & Neuhaus, C. (2021). Magdalena Martullo-Blocher: «Der Bund hat eine Diktatur eingeführt. Er hat die Demokratie ausgeschaltet». Neue Zürcher Zeitung. https://www.nzz.ch/schweiz/magdalena-martullo-blocher-der-bund-hat-eine-diktatur-eingefuehrt-er-hat-die-demokratie-ausgeschaltet-ld.1601336

- Bogle, A. (2020). Sinister sounds: podcasts are becoming the new medium of misinformation. The Guardian. https://www.theguardian.com/media/2020/dec/12/sinister-sounds-podcasts-are-becoming-the-new-medium-of-misinformation

- deepset.ai (2020). bert-base-german-cased-hatespeech-GermEval18Coarse. Hugging Face. https://huggingface.co/deepset/bert-base-german-cased-hatespeech-GermEval18Coarse

- Goodman, J., & Carmichael F. (2020). The coronavirus pandemic ‚Great Reset‘ theory and a false vaccine claim debunked. BBC News. https://www.bbc.com/news/55017002

- Google Developers (2021). YouTube Data API V3. https://developers.google.com/youtube/v3

- JooYoung S. & Soyoung C. (2020). youtubecaption: Downloading YouTube Subtitle Transcription in a Tidy Tibble. https://github.com/jooyoungseo/youtubecaption Data Frame. R package version 1.0.0.

- Kelland, K. (2021), ‚Crazy and evil‘: Bill Gates surprised by pandemic conspiracies. Reuters. https://www.reuters.com/article/us-health-coronavirus-gates-conspiracies-idUSKBN29W0Q3

- Köppel, R. (2021), Weltwoche Daily. Weltwoche Verlags AG/YouTube. https://www.youtube.com/channel/UCq-b0dwW97YRZWgSCikWQRA

- Michel, P., & Hourni L. (2021). BAG-Sitz in Bern erhält wegen Drohungen Polizeischutz. 20 Minuten. https://www.20min.ch/story/bag-sitz-in-bern-erhaelt-wegen-drohungen-polizeischutz-695333033447

- Munger, K., & Phillips, J. (2020). Right-Wing YouTube: A Supply and Demand Perspective. The International Journal of Press/Politics. https://doi.org/10.1177/1940161220964767

- Munn, L. (2020). Angry by design: toxic communication and technical architectures. Humanities and Social Sciences Communications, 7(1), 1-11. https://www.nature.com/articles/s41599-020-00550-7

- Perez, S. (2020). YouTube introduces new feature to address toxic comments. TechCrunch. https://techcrunch.com/2020/12/03/youtube-introduces-new-features-to-address-toxic-comments/

- R Core Team (2021). R: A language and environment for statistical computing. R Foundation for Statistical Computing, Vienna, Austria. URL https://www.R-project.org/.

- Ribeiro, M. H., Ottoni, R., West, R., Almeida, V. A., & Meira Jr, W. (2020, January). Auditing radicalization pathways on YouTube. In Proceedings of the 2020 conference on fairness, accountability, and transparency (pp. 131-141). https://arxiv.org/abs/1908.08313

- Roberts, M. E., Stewart, B. M., & Tingley, D. (2019). Stm: An R package for structural topic models. Journal of Statistical Software, 91(1), 1-40.

- Rohde D. (2020). How America Escapes Its Conspiracy-Theory Crisis. The New Yorker. https://www.newyorker.com/news/the-future-of-democracy/how-america-escapes-its-conspiracy-theory-crisis

- Sager, B. (2021a). Fork of tuber: Access YouTube from R. R package version 0.9.9. https://github.com/balthasars/tuber

- Sager, B. (2021b). wrappingtransformers: R wrapper for some Transformers models published at Hugging Face. R package version 0.1.0. https://github.com/balthasars/wrappingtransformers

- Salminen, J., Sengün, S., Corporan, J., Jung, S. G., & Jansen, B. J. (2020). Topic-driven toxicity: Exploring the relationship between online toxicity and news topics. PloS one, 15(2), e0228723.

- Schmid, S. (2020), Klimajugend sagt «Arena»-Auftritt wegen Roger Köppel ab. Neue Zürcher Zeitung. https://www.nzz.ch/schweiz/klimajugend-sagt-arena-auftritt-wegen-roger-koeppel-ab-ld.1578304

- SDA (2019), Die Überflieger, die Frauen, die Abgewählten und die Jungen. Tages-Anzeiger. https://www.tagesanzeiger.ch/schweiz/standard/wahlbeteiligung-tiefer-als-2015/story/27906251

- Sood, G. (2021). tuber: Access YouTube from R. R package version 0.9.9. https://github.com/soodoku/tuber

- Tait, A. (2016). Why Are YouTube Comments the Worst On the Internet?. New Statesman. https://www.newstatesman.com/science-tech/internet/2016/10/why-are-youtube-comments-worst-internet

- Wiegand, M., Siegel, M., & Ruppenhofer, J. (2018). Overview of the germeval 2018 shared task on the identification of offensive language.

- Wickham et al., (2019). Welcome to the tidyverse. Journal of Open Source Software, 4(43), 1686, https://doi.org/10.21105/joss.01686

- Weltwoche Verlags AG (2021). Disclaimer Kommentarfunktion. https://www.weltwoche.ch/ueber-uns/impressum-disclaimer.html